自动化之后,SOC 该如何迈向智能化?

引言:从自动化到智能化,SOC 正在经历什么?

如果你的 SOC 正在经历从 自动化 走向 智能化 的阶段,那么下面这些思考,或许会对你有所帮助。

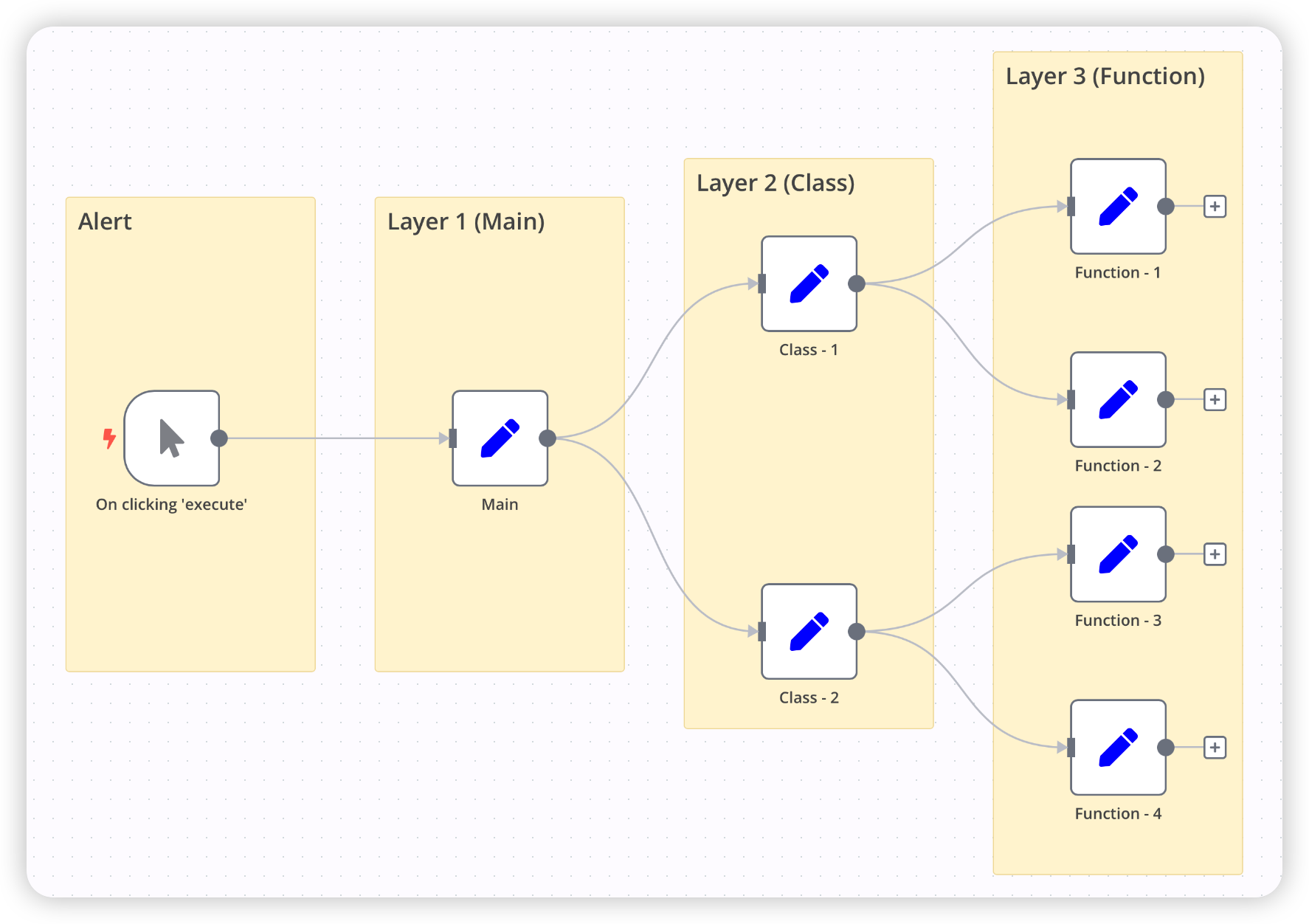

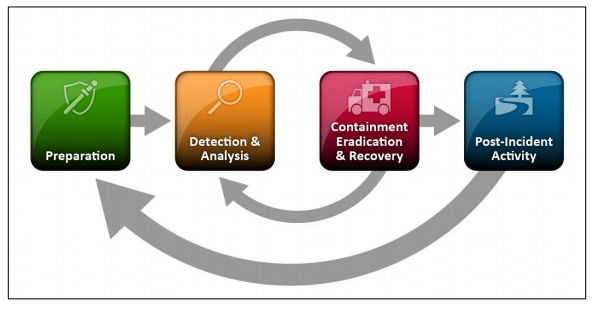

在 SOC 的自动化阶段,我们做的事情其实非常清晰:

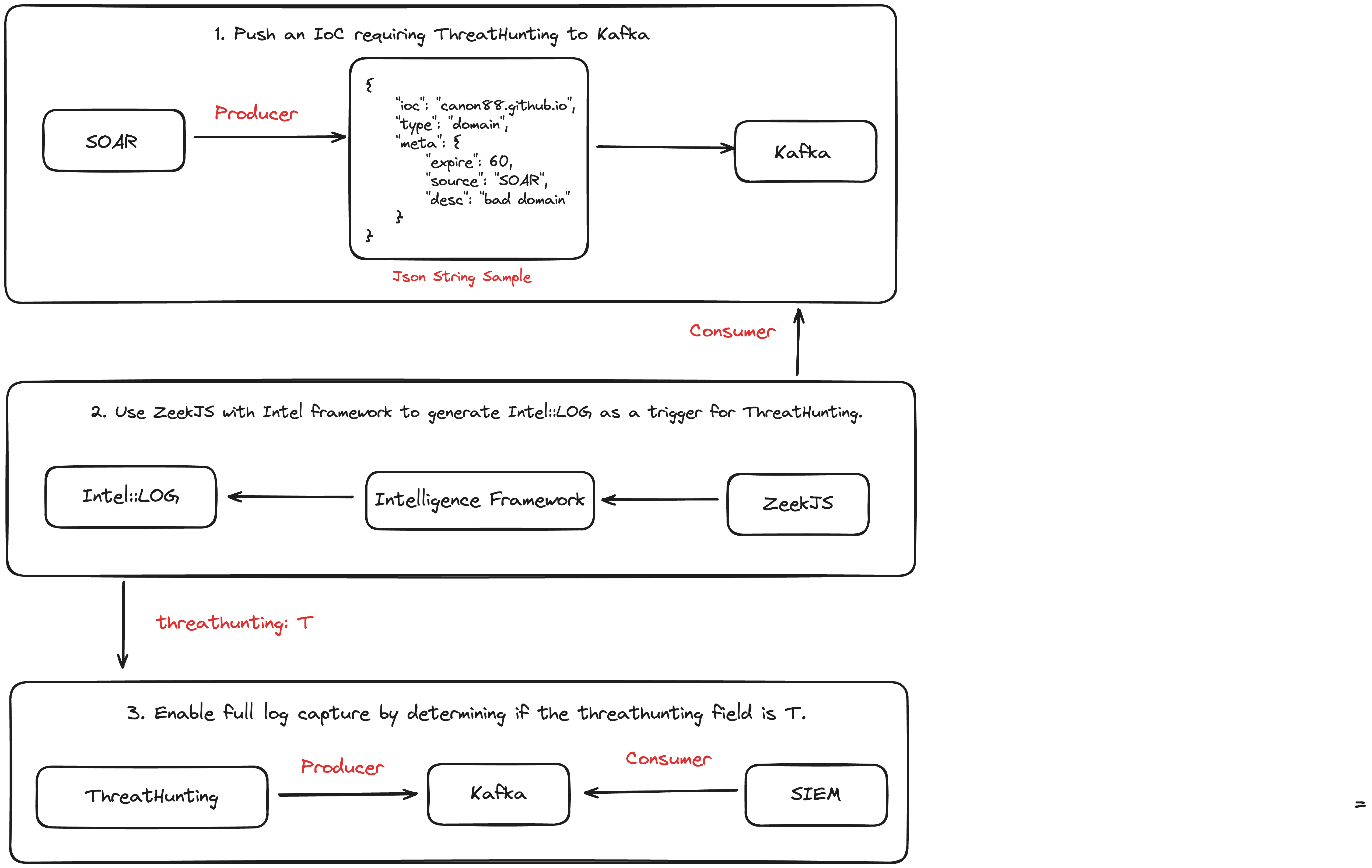

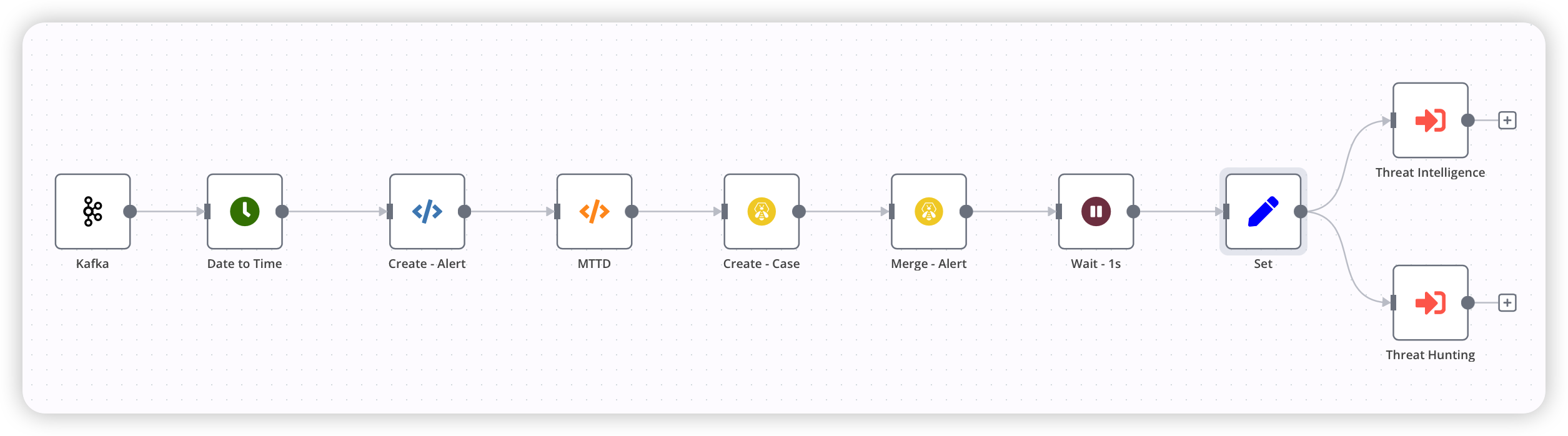

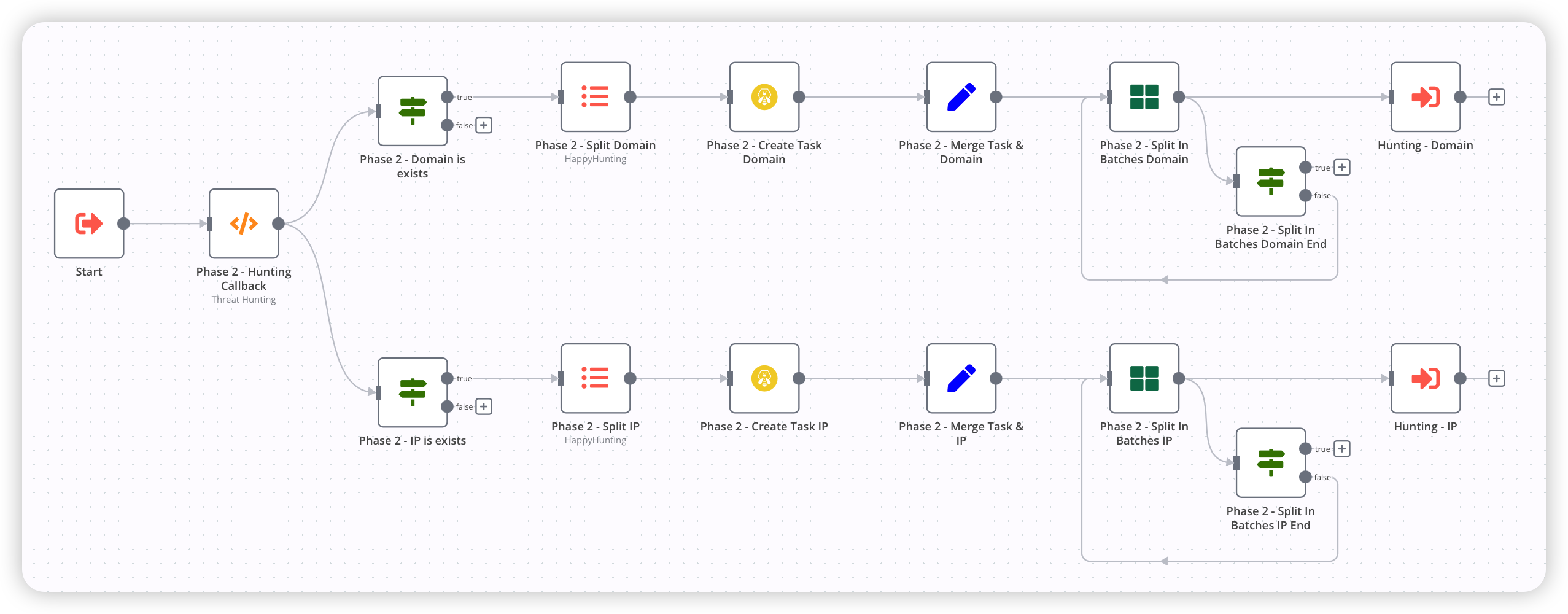

将个人经验沉淀为 SOP,再通过 SOAR 将 SOP 转换为可执行的「剧本」。

这些剧本对 入参、出参以及执行路径 都有严格约束——这正是自动化最核心的优势所在:

自动化擅长解决「已知问题 + 已知路径」。

一旦条件满足,执行高效、稳定且可规模化。

但随着剧本数量不断增加,问题也逐渐显现。

一方面,自动化天然依赖 确定性输入。只要告警或事件稍微偏离预期路径,剧本就无法命中,最终仍需要人工介入。久而久之,便会出现一种并不陌生的现象:

剧本在不断沉淀,但真正被高频使用的却越来越少。

另一方面,当面对 跨系统、跨阶段、信息不完整 的复杂安全事件时,我们会发现,问题本身已经不再是”流程是否完整”,而是:

如何在不确定的信息中完成研判与调查。

而这,恰恰是传统自动化最不擅长的部分。

也正是在这样的背景下,近几年 AI,尤其是 LLM 的快速发展,为处于「重度自动化阶段」的 SOC 团队提供了一个新的契机。

通过引入 AI 的 推理与判断能力,SOC 开始有机会在 研判 与 调查 这两个高度依赖经验的环节中,弥补自动化在不确定性场景下的天然短板,从而迈向真正意义上的智能化阶段。

需要强调的是,这并不意味着 SOC 可以跳过”自动化”阶段,直接进入所谓的「AI SOC」。

恰恰相反:

自动化,是智能化 SOC 不可或缺的基础层。

在引入 AI 之后,SOC 面临的并不是”是否还需要自动化”,而是:

如何重新定义自动化在整个运营体系中的角色!

AI 不是替代自动化,而是“消耗自动化沉淀”的上层能力

AI 并不是直接解决安全问题的能力。它本质上是建立在自动化之上的一种 能力放大器。用于消化、调用并放大既有能力。

AI 本身并不具备执行力。真正决定 AI 能走多远的,始终是 SOC 在自动化阶段已经沉淀下来的能力基础。

1. 没有自动化,AI 只能停留在“建议”

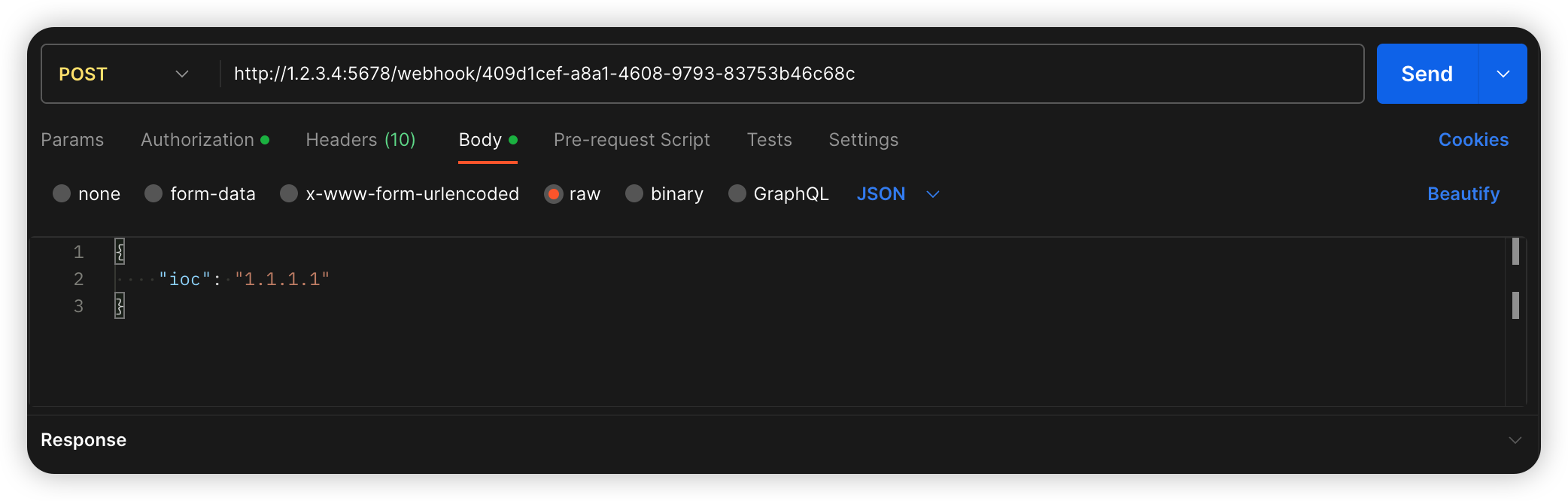

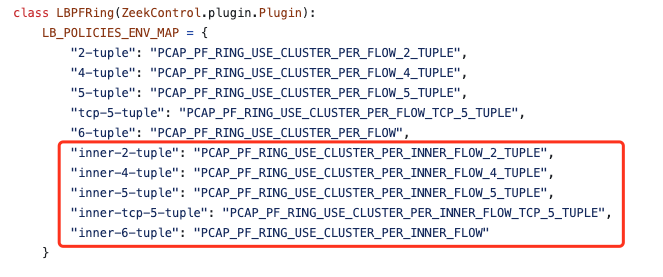

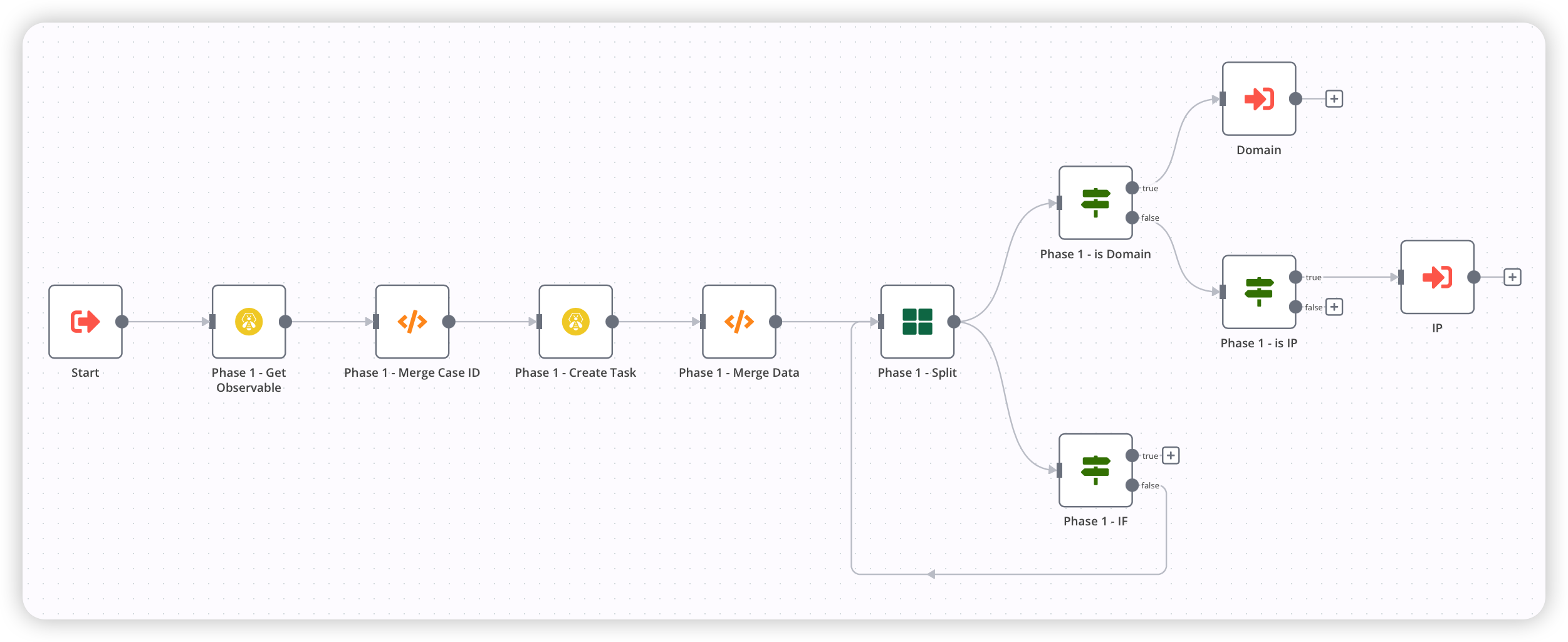

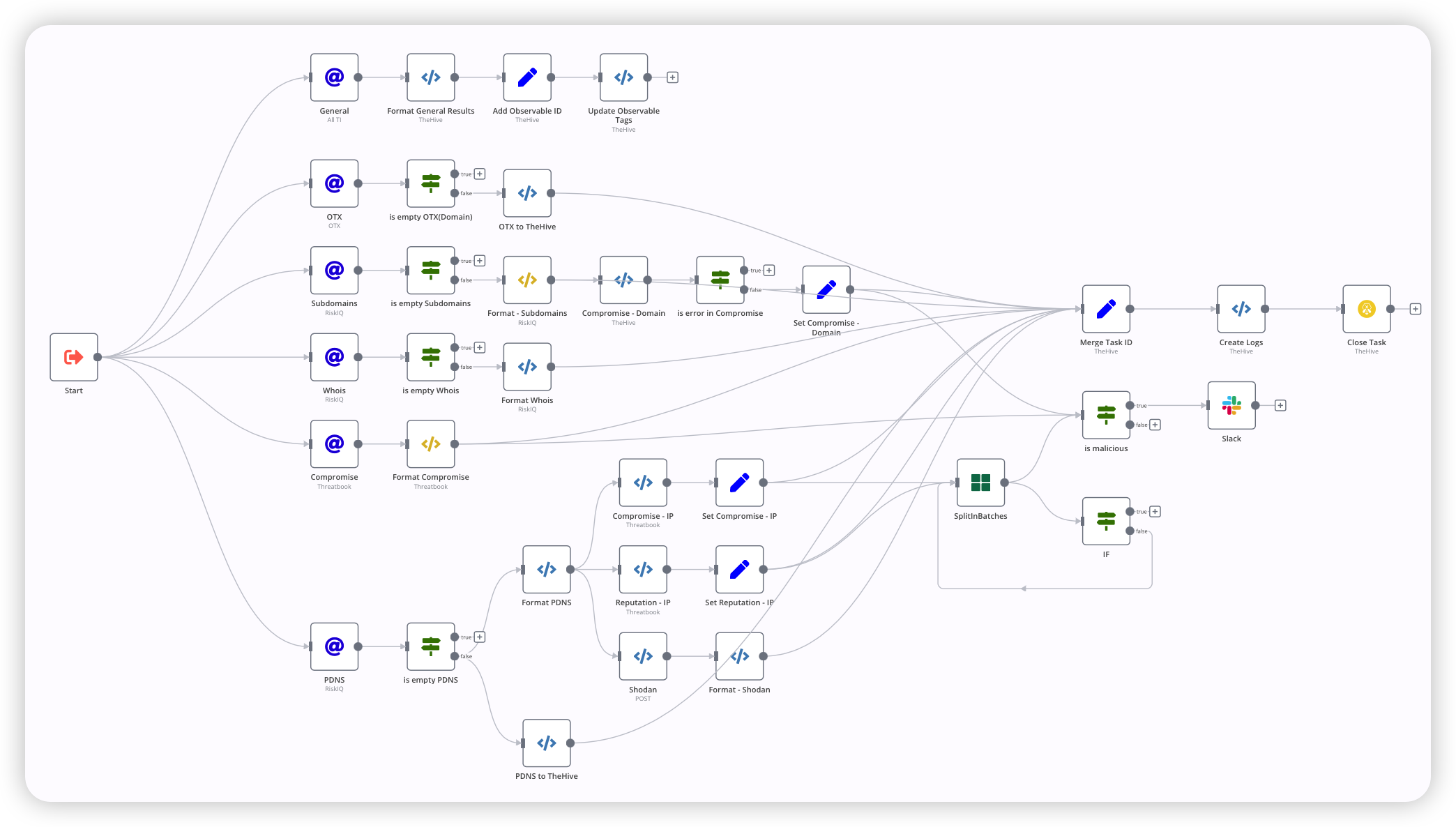

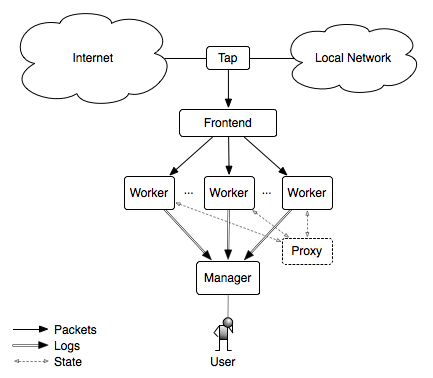

AI 并不能直接作用于真实环境。它需要 可调用、可执行、可审计 的底层能力作为支撑。这意味着,在自动化阶段沉淀下来的原子能力,需要以 MCP Tools 的形式暴露给 AI 使用。

如果缺乏这些原子能力:

- AI 无法真正调用真实世界的能力;

- 只能停留在分析、推理和“给建议”的层面;

- 无法形成闭环,更谈不上规模化落地。

2. 没有 SOP,AI 的判断无法落地

在自动化阶段我们努力让 SOP 不被“挂在墙上”。在智能化阶段,SOP 不会消失,反而变得更加重要。SOP 不再只是给人看的操作说明,而是一种:约束与引导机制。它为 AI 提供 符合真实环境、组织策略与安全边界的处理路径。

换句话说:SOP 决定了 AI「可以怎么做」,而不仅仅是「应该怎么想」。

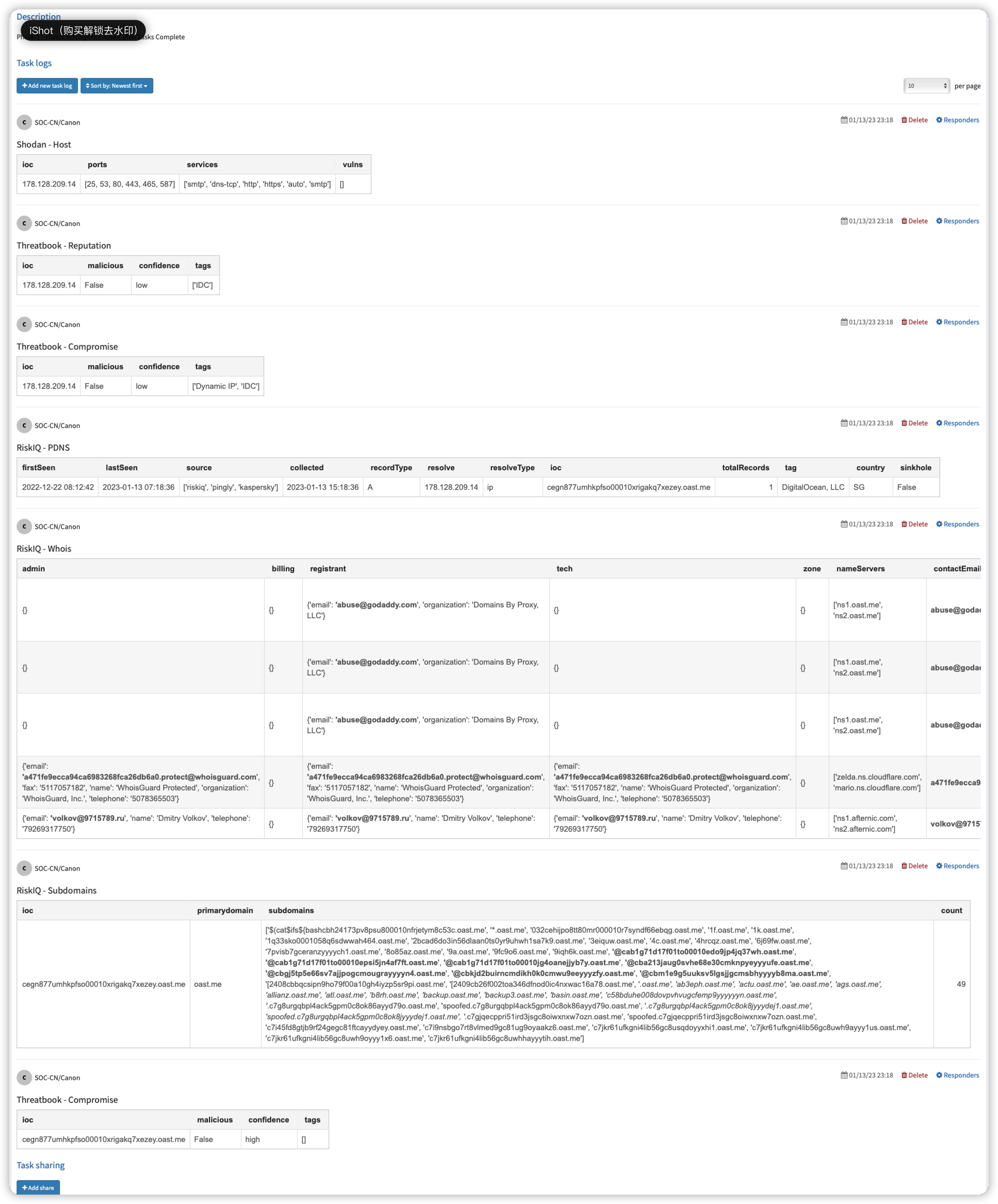

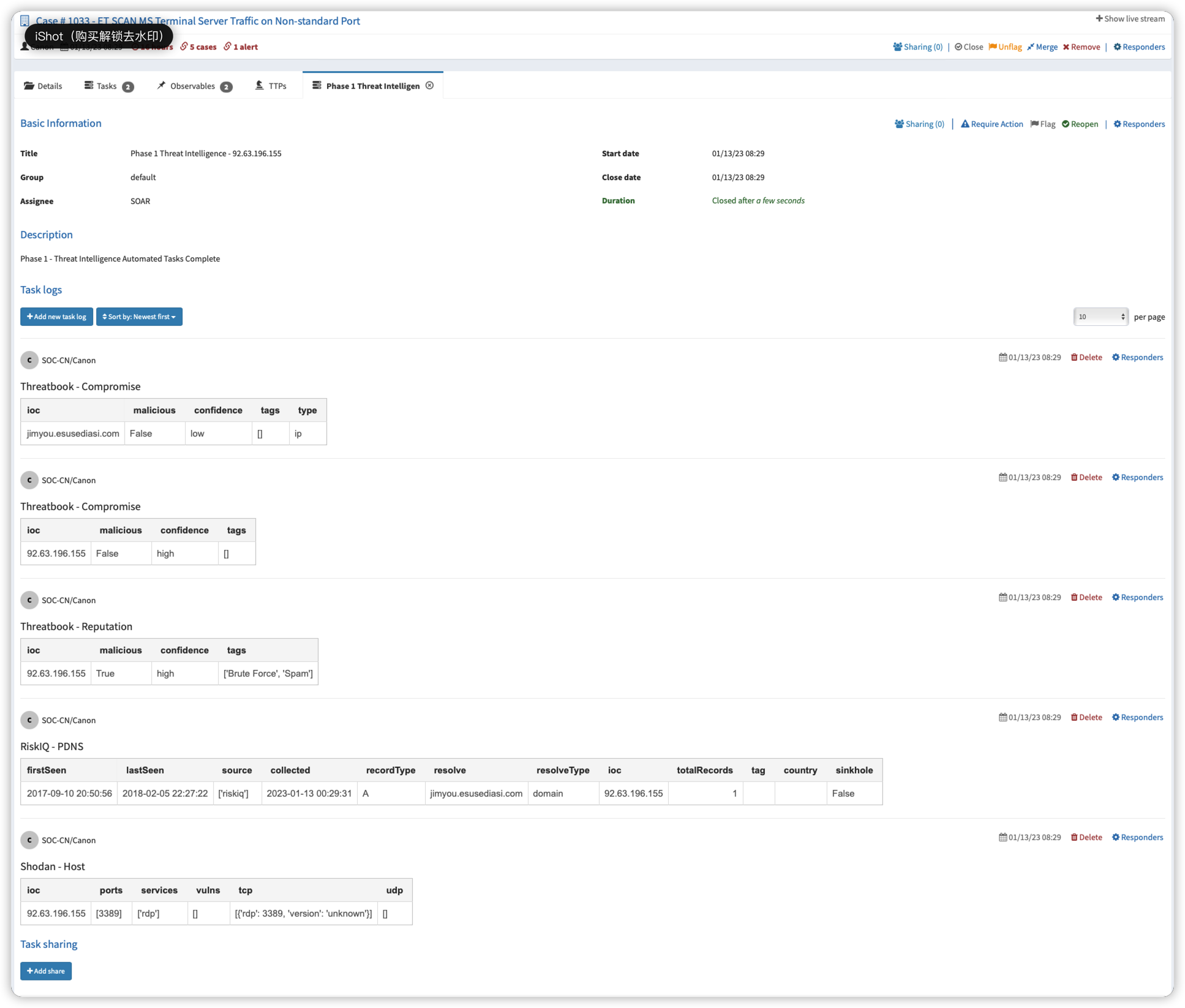

此外,在实际运行中,自动化往往还承担着一个容易被忽视的角色:信息准备层。通过自动化手段对告警进行上下文补充、资产关联、情报拉取与数据聚合,可以在进入 AI 研判之前,就将信息尽可能 结构化、丰富化:

- 减少 AI 的重复调用;

- 降低整体运行成本;

- 提升研判稳定性与一致性。

因此,在迈向智能化 SOC 的过程中,自动化并没有被削弱,而是完成了一次角色转变:

从「流程执行者」转变为「能力提供者」和「信息放大器」。

为什么研判与调查,才是 AI 最适合介入的环节?

研判与调查,是 SOC 中 不确定性最高、规则最难穷举、却又高度依赖经验 的环节。

而这,恰恰是 AI 最擅长、也是传统自动化最”无能为力“的地方。

1. 研判与调查的本质,是在不完整信息中做判断

与检测规则或自动化处置不同,研判与调查面对的,往往并不是”条件是否满足”,而是:

- 告警信息不完整,甚至存在噪声;

- 数据分散在多个系统中,需要横向关联;

- 事件是否构成风险,依赖上下文而非单一指标;

- 同一类告警,在不同业务、不同资产背景下,结论可能完全不同。

这类问题,很难通过固定规则或条件穷举来解决,却高度依赖:

- 经验积累;

- 模式识别;

- 对业务与环境上下文的理解。

而这,正是 LLM 最擅长的!

2. 自动化擅长”执行”,但不擅长”判断”

自动化在 SOC 中的价值非常明确:路径清晰、条件明确、结果可预期。

它非常适合处理:

- 批量化、重复性任务;

- 明确的处置流程;

- 可被标准化的操作动作。

但研判与调查恰恰相反:

- 很多判断不是”是否满足条件”,而是”是否合理”;

- 很多结论不是二元判断,而是带概率与置信度的判断;

- 调查路径需要根据中间结果不断调整,具有明显的动态性。

如果强行用剧本去覆盖研判与调查阶段,通常只会出现两个结果:

- 剧本复杂度不断上升,却依然无法覆盖所有场景;

- 分析师开始绕过自动化,回到完全依赖人工的分析模式。

AI 的引入,本质上是:填补自动化在「判断层」的 空白。

3. 从落地角度看,这是 AI 最容易”真正落地”的切入口

在”真实世界”的 SOC 工作中,引入 AI 往往面临两个非常现实、且不可回避的约束:

- 不能影响生产稳定性;

- 不能引入不可控的误操作风险。

这意味着,AI 很难一开始就参与”处置”。在此阶段我们需要与 AI 建立”信任”。

相比之下,将 AI 优先引入研判与调查阶段,是一个更现实、也更稳妥的切入口:

- 不直接接管处置权,最终决策仍由人完成;

- 不改变既有检测链路,避免对生产环境产生影响;

- 不引入破坏性操作风险,即便判断失误,代价也可控。

但与此同时,它可以带来非常直接、可量化的收益:

- 显著降低人工分析的时间成本;

- 提升告警研判的一致性与稳定性;

- 缓解 Tier 1 分析师的人力瓶颈。

这使得 AI 在 SOC 中的角色,更像是一个:

可逐步放权、可持续验证价值的”增强型分析能力”,而不是一次性、大规模替换人的”黑盒系统”。

也正因为如此,研判与调查,往往成为 AI 在 SOC 中 最先真正跑起来、且最容易跑稳的场景。

为什么要优先从告警研判入手?

在 SOC 的日常运行中,大量工作并不是在处理「已确认的安全事件」,而是在对 源源不断的告警进行研判,确保它们被 正确分流和处置。

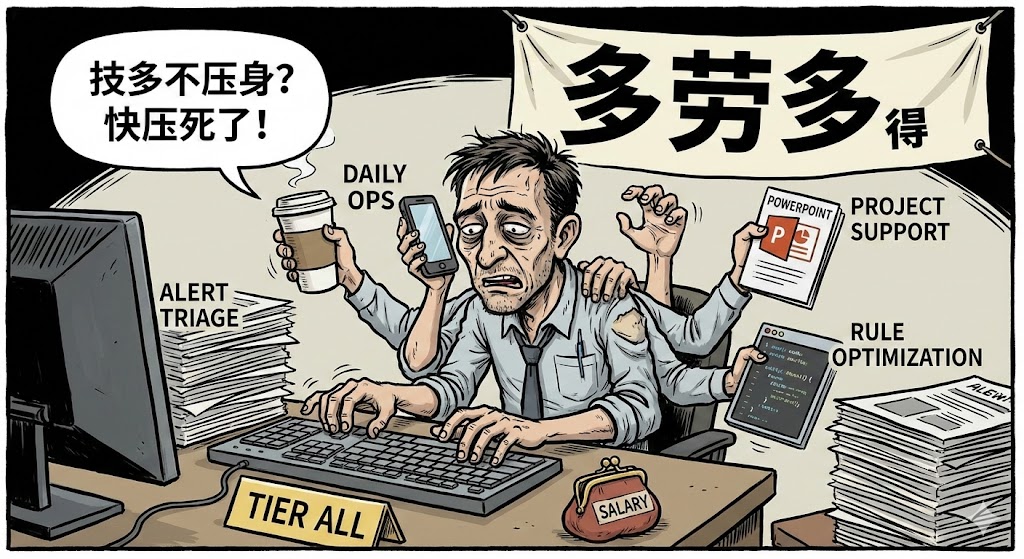

现实中,这部分工作通常由 Tier 1 分析师承担,而在国内环境下,很少存在”只做研判“的纯 Tier 1 角色。更多时候,分析师需要在告警研判、日常运营、规则优化甚至项目支持之间反复切换。这使得 告警研判成为最消耗人力、同时也最容易成为瓶颈的环节。

因此,将 AI 优先引入告警研判阶段,往往可以在 不改变 SOC 整体架构 的前提下,显著释放分析师的时间与精力。

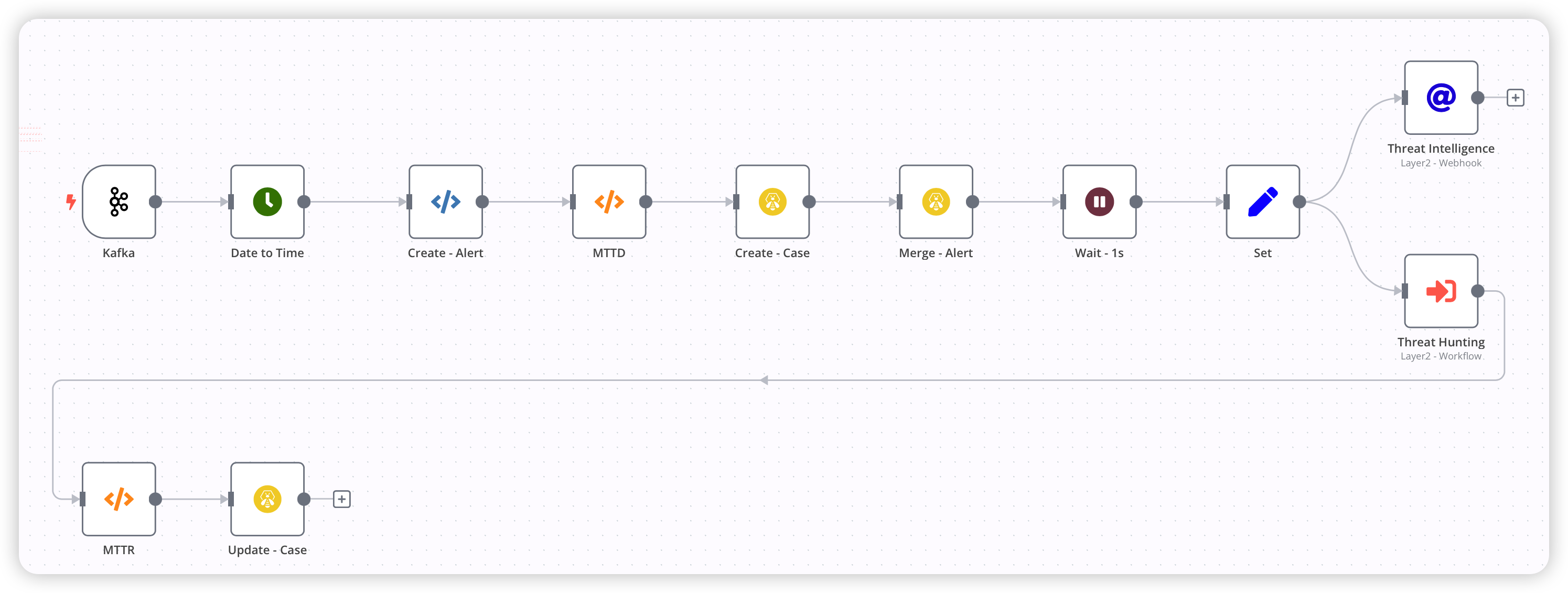

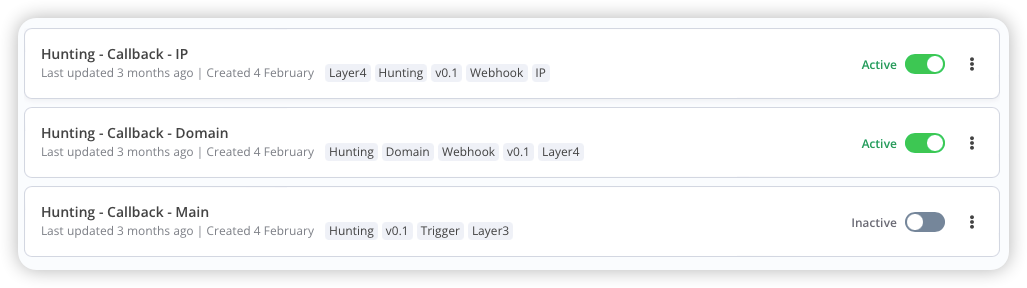

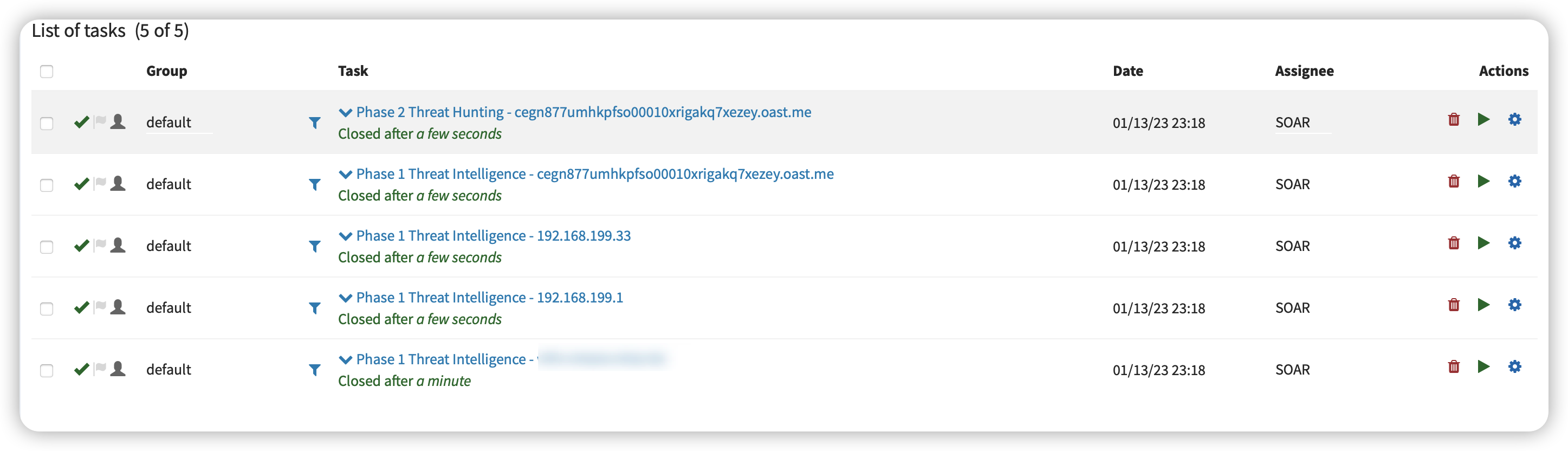

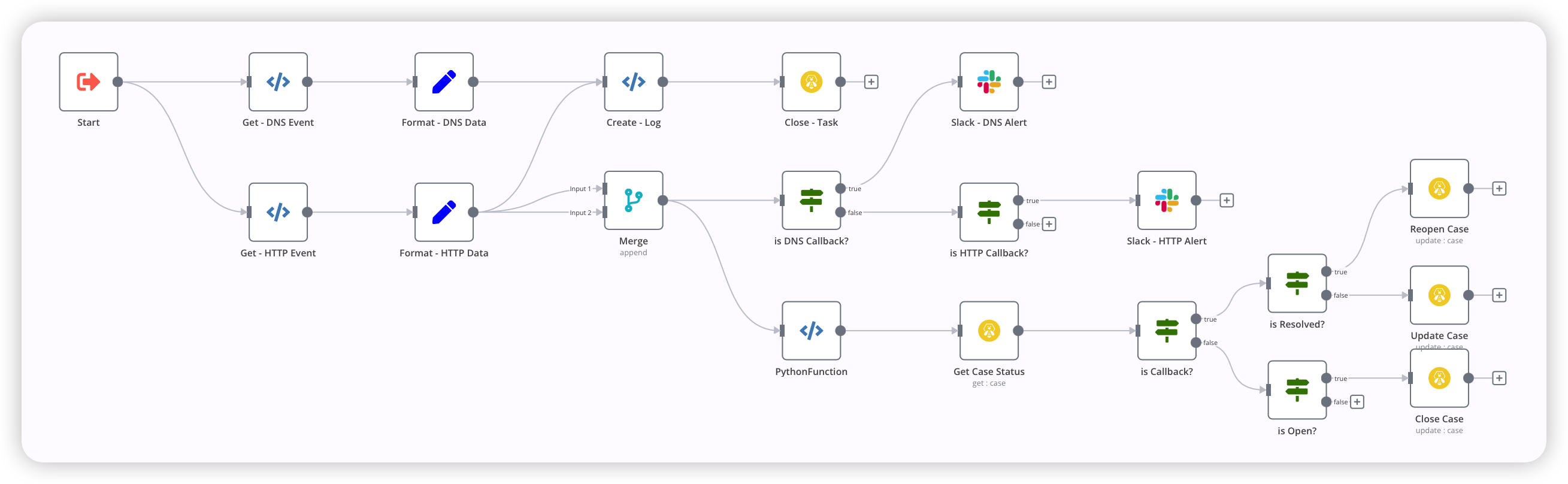

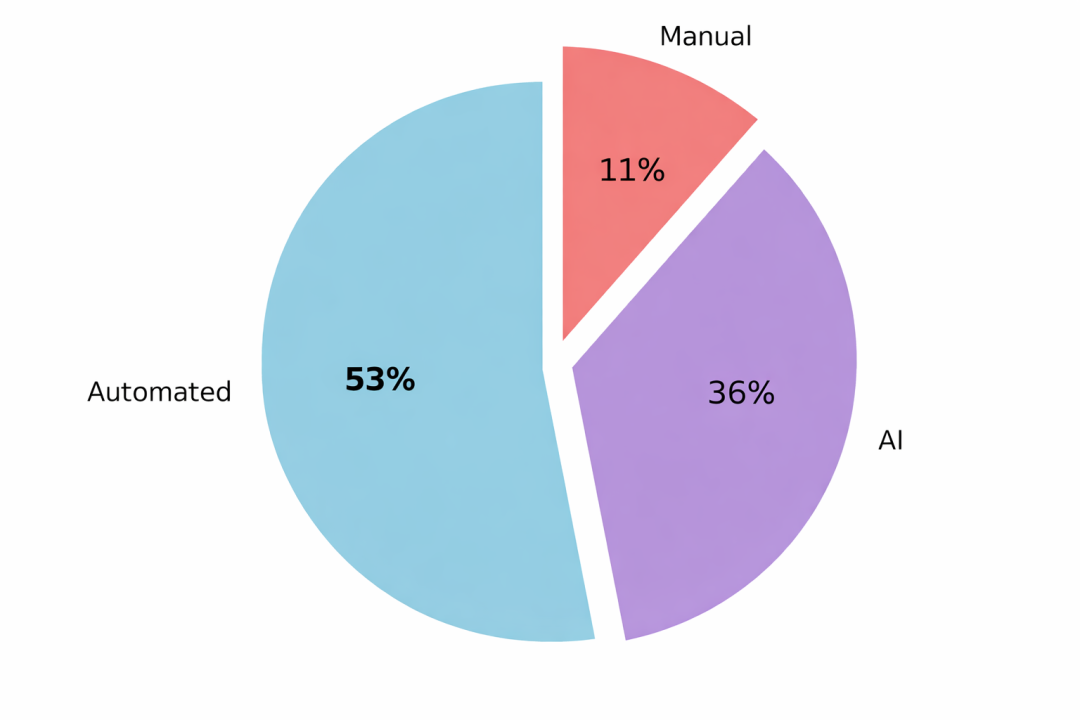

通过 SOAR + AI 的组合:

- 自动化负责信息收集、上下文补全与初步归并;

- AI 在已有信息基础上完成快速分析与定性建议;

- 人只需对关键告警进行最终确认。

优先选择告警研判,并不是因为它”简单”,而是因为它决定了 SOC 是否能把有限的人力,用在 更具研究价值的工作上:检测工程、威胁狩猎或安全研究。

研判与调查:是必须被严格区分的两件事!

研判决定是否升级,调查决定如何响应。

两者边界越清晰,AI 才越容易安全落地。

在实践中,一个常见且”危险”的误区,是 将”告警研判”和”事件调查”混为一谈。这不仅会拉高研判阶段的复杂度,也会让 AI 的使用边界变得模糊甚至 失控。

告警研判(Alert Triage)

- 核心问题:这是真的攻击,还是误报?

- 目标:降噪与定性

- 关注点:速度、一致性、可解释性

- SOC 视角:分诊台

事件调查(Incident Investigation)

- 核心问题:攻击者是谁?影响了什么?如何进入?

- 目标:溯源与定损

- 关注点:深度、完整性、可复现性

- SOC 视角:手术室

AI 撕开了运营的”遮羞布”

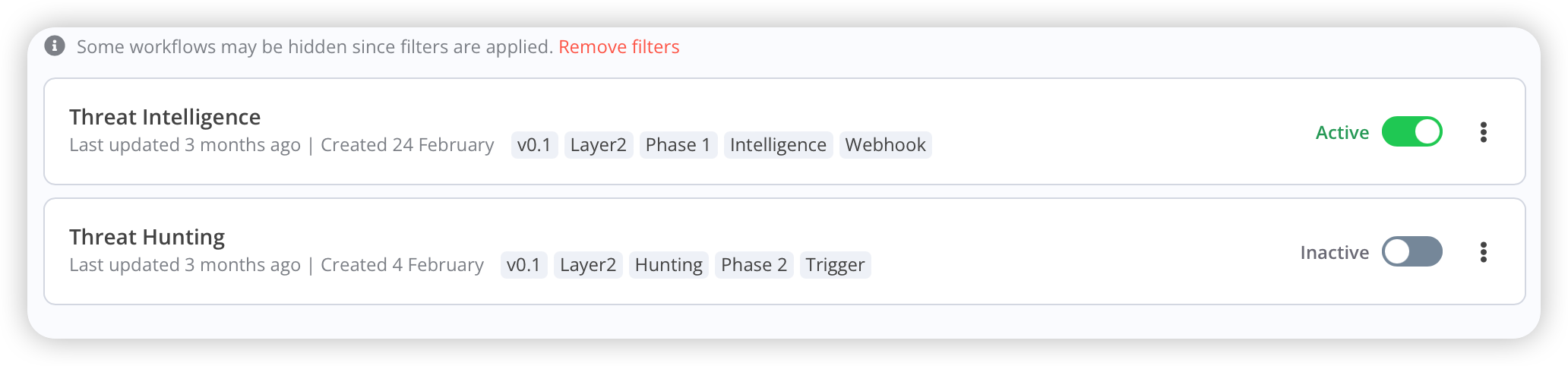

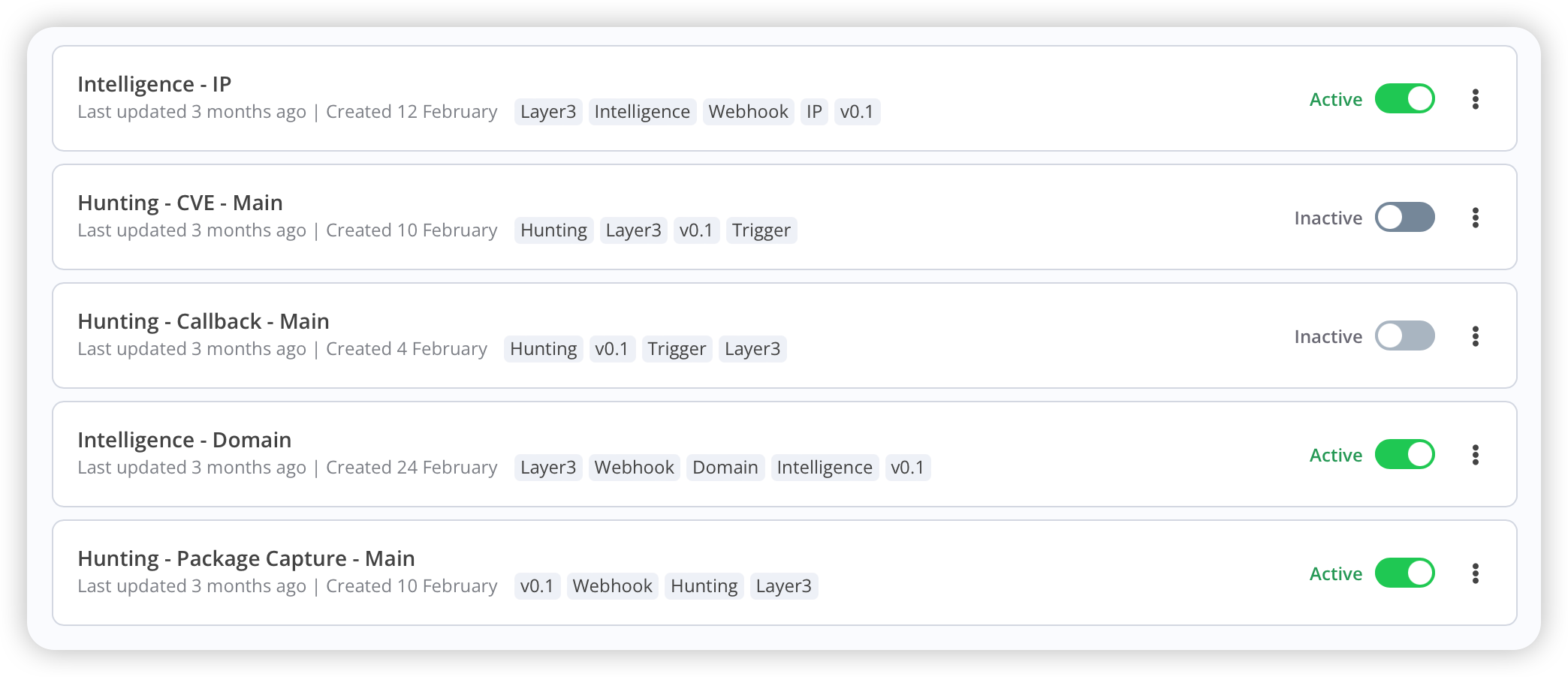

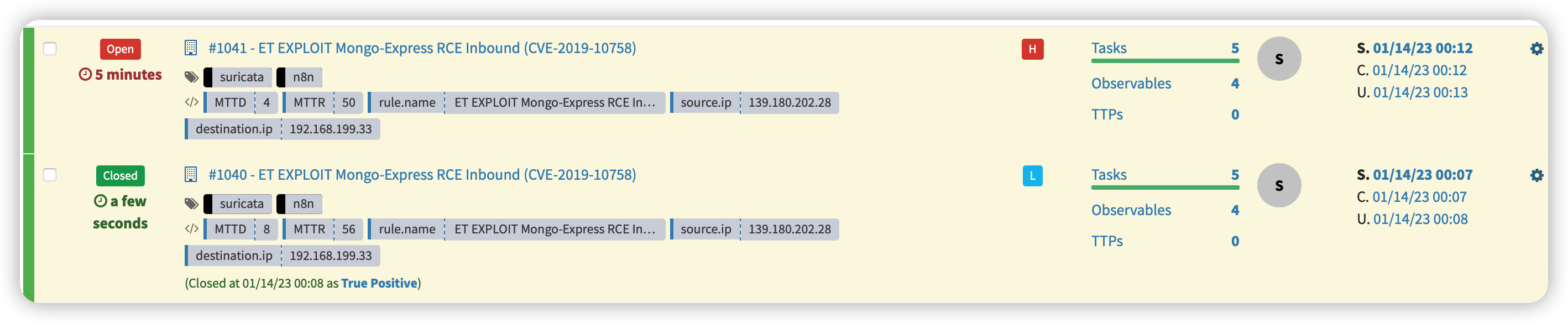

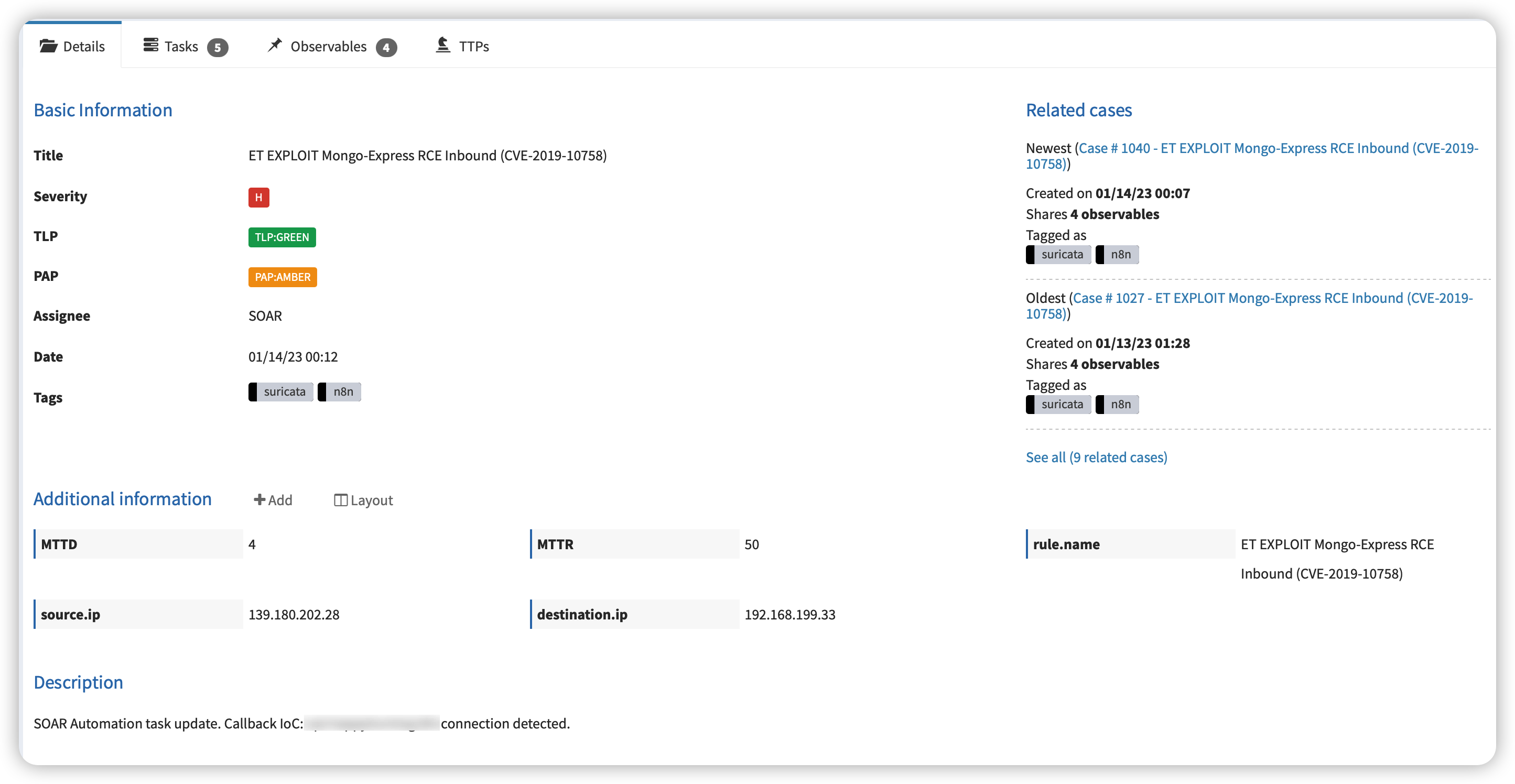

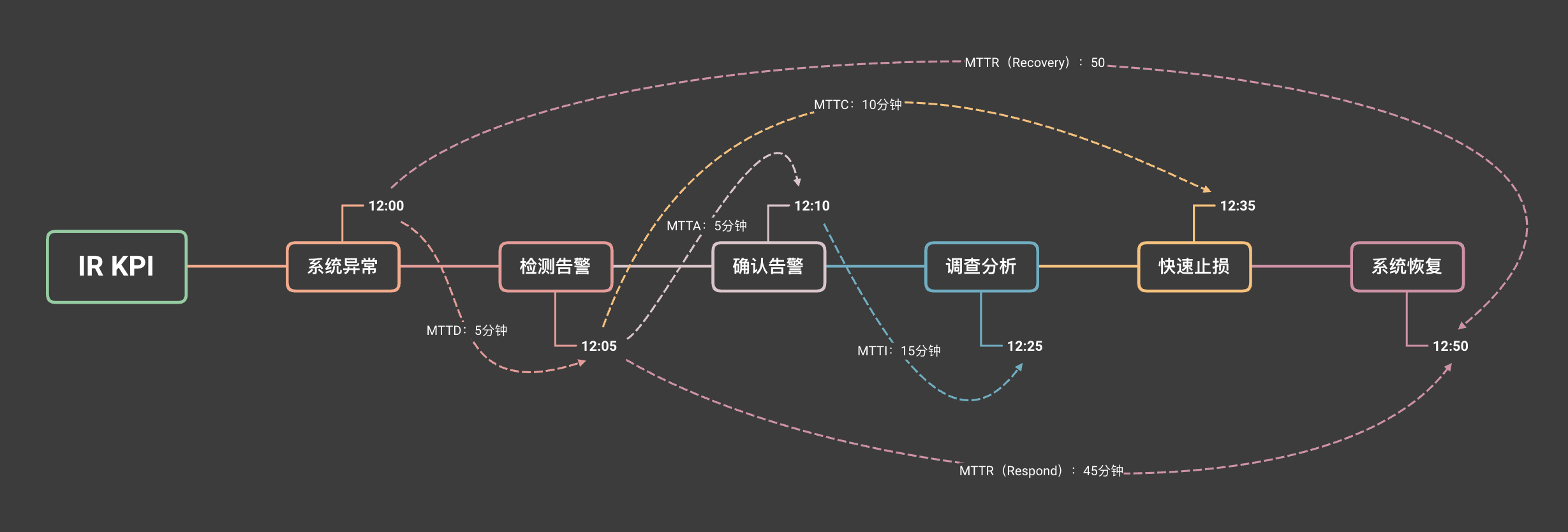

过去一年,我们在 SOC 运营中全面引入 AI,并将其与既有的自动化体系(SOAR)深度融合。

从指标上看,这是一场”胜利“:Tier 1 分析师从重复劳动中被解放出来,复杂 Case 的吞吐量提升,整体 MTTR 明显改善。

但当 AI 真正进入 日常、高频、规模化 的研判流程后,我们很快意识到一件事:

AI 并没有自动让研判变得更稳定,反而像一面 放大镜,撕开了 SOC 运营体系中原本被掩盖的问题。

最先暴露出来的,并不是检测能力、数据质量,甚至也不是模型能力,而是一个长期被忽视的基础问题:

告警研判的 一致性 与 可复用性。

在没有 AI 的时代,这些问题是被”默许”的

在传统 SOC 运营模式下,研判质量高度依赖个人经验:

- 不同分析师对同一类告警,结论可能并不一致;

- 资深分析师往往能快速给出 “正确但难以解释” 的判断;

- 这些差异被默认为”经验差距”,并被组织所接受。

从结果上看,这种状态虽然低效,但仍处于一种 “软性可控” 的状态 —— 因为问题只存在于个体之间,而不是被系统性放大。

进入 AI 时代后,问题被系统性放大

当 AI 介入研判之后,情况发生了变化。

如果缺乏 清晰 的 SOP 与经验约束,AI 会对同一类告警:

- 给出风格差异极大的分析结论;

- 采用逻辑路径不一致的判断方式;

- 甚至在不同时间,对同一问题给出 相互矛盾 的结论。

处在自动化阶段的 SOC,可以通过 SOAR 做很多事。但 SOAR 始终只能提供 “冷冰冰的数据上下文“:

- 字段

- 日志

- 关联关系

- 历史次数

但它无法回答一个关键问题:

“在我们这个组织里,这类告警通常是如何被理解和处理的?”

也正是在这个阶段,我们逐渐意识到:

如果没有经验约束,AI 只会把研判差异放大成系统性风险。

SOP,决定了 AI 研判的”下限”

在告警研判与事件处理中,AI 并不是凭空做判断。

它所采用的分析路径、检查步骤与决策逻辑,本质上来源于两类资产:

- SOP

- 历史 Case

如果这两者本身是模糊的、不完整的,那么 AI 的输出只会显得 “看起来合理“,却无法保证 一致性 与 可复用性。

一个直观的对比(SOP):国内 vs 海外

从我的个人观察来看,海外团队 在 SOP 的标准化与细化程度上,整体要优于国内。

我看过不少海外分析师留下的 Case 记录和 SOP,从国内的视角来看,这些内容往往显得:

- 很繁琐;

- 很基础;

- 甚至有些”笨笨的”。

但他们会非常明确地写出:

- 每一步具体要查什么数据;

- 为什么查这个数据;

- 在什么条件下得出什么结论;

- 哪些情况可以直接终止分析。

而在国内 SOC 的现实环境中,我们更常见的是另一种写法:

- “检查日志确认无异常”

- “确认资产为测试环境”

- “综合判断为误报”

这些描述方向未必是错的,但它们存在一个致命问题:

无法被直接执行。无论是给新人,还是给 AI。

这一点我感触很深,我的新加坡团队成员就曾和我反馈过,为什么国内的小伙伴处理的Case,总是”轻描淡写”的写一句:”综合判断误判 或 运维正常操作”,并不会写明判断过程和附上判断依据。

这背后当然有现实原因:

- 国内更强调效率,要求一人身兼多职

- 日常运营压力大,很难抽出时间系统性沉淀文档

- 能偶尔写一篇 Blog,已经算是”幸运”

在这样的环境下,很少能够有时间对历史 Case 做标准化抽象,再进一步整理为 可复用、可传承的 SOP。这是需要分析师有专注的时间去打磨的。

当 AI 进入研判流程后,这种差距会被迅速放大。

这听起来 非常基础,但这正是大多数 SOC 团队不愿面对的”运营债“—— 知识库与 SOP。

列举2个常见的场景

场景一:模糊历史的「族谱索引」

这是资深分析师最难被传承的一类直觉能力:

“这个告警,我好像半年前见过。”

现实中的典型场景包括:

- 某个业务系统存在罕见 Bug,会周期性触发异常请求;

- 半年前曾有分析师深入排查,并在工单中留下明确结论;

- 由于特征不稳定,无法通过规则或白名单彻底解决。

在这种场景下:

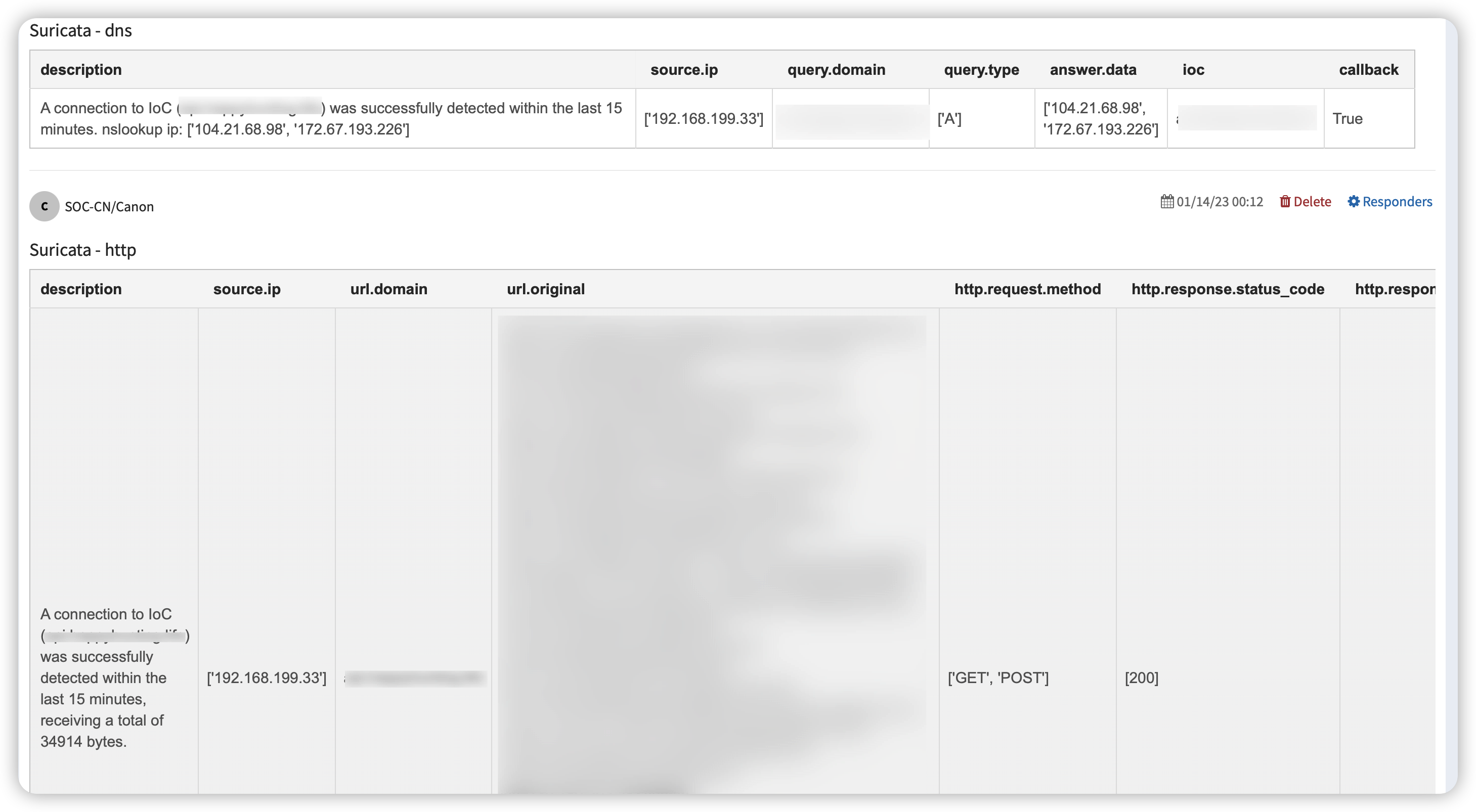

- SOAR 能提供的是 数据:相似字段、历史出现次数、时间分布;

- 却给不出 经验:当时是如何判断的?为什么最终被忽略?

如果没有知识库或结构化的历史 Case,这类经验只能停留在个人脑海中。

而当 SOP 与历史 Case 被系统化沉淀 后,AI 可以在研判阶段明确指出:

“这类告警在我们组织内部,历史上是如何被理解和处理的。”

❗️温馨提示:

这并不是让 AI “拍板”,而是让 AI 继承组织的集体经验。

场景二:研判质量的「下限固化」

另一个在真实运营中反复出现的问题是:

- 同一类告警,不同分析师的研判质量差异极大;

- 某些分析师的处理方式被公认为”教科书级别”;

- 但这种高质量研判,无法被稳定复用。

在没有 AI 的情况下,这种差异虽然存在,但影响范围有限。

而在引入 AI 之后,如果缺乏 SOP 约束,这种问题会演变为:

- 研判逻辑过度发散;

- 输出风格不断漂移;

- 甚至出现 “逻辑自洽,但结论错误” 的幻觉。

在这一场景下,SOP 的价值恰恰不是提升 AI 的上限,而是:固化分析路径,保证研判质量的下限。

SOP 在这里扮演的角色,并不是”告诉 AI 答案”,而是:

- 明确哪些检查是 必须做的;

- 哪些结论是 不能轻易给出的;

- 哪些判断需要满足 明确前提。

SOP 是 AI 分析研判阶段的”安全护栏”

在 AI 时代,那些看起来 “笨笨的 SOP“,反而成了最有价值的资产:

- 为 AI 提供明确、可执行的分析路径;

- 天然适合作为知识库与高质量 Case 的来源;

- 让 AI 始终运行在一个 稳定、可控的判断框架 之内。

在实践中你会发现:

- 自动化越成熟,AI 的建议越容易落地

- SOP 越清晰,AI 的研判越稳定可控

反之:

- 自动化混乱,AI 的判断无法执行

- SOP 模糊,AI 的判断无法复用

所以:

往往并不是”AI 不行”,而是 AI 把 SOC 的基础问题照得更清楚了。

SOP 不是为了让 AI 更聪明,而是为了让它不犯低级错误,守住研判的下限。

结束语:用好 AI,本质上是在”逼迫” SOC 回归基础

AI 无法替代清晰的 SOP,也不会替你补齐基础能力,它只会非常诚实地放大你已经具备的能力。

当你觉得 AI 不好用时,真正的问题往往不是 AI,而是:

AI 把 SOC 的基础问题照得更清楚了。